大多数营销人都在试图让营销活动从各方面都成为数据驱动的,但由于现实条件限制,标准的、常规的测试方法并不适用于所有场合。

当常用的A/B测试手段不能解决营销问题时该怎么办?看看网飞的解决办法。

众所周知,网飞是一家非常实验导向的公司。实验为网飞的大部分决策提供了依据。网飞通过严谨地设计、分析和执行每一个实验,来确保所做的更改对其用户和业务发展来说是正确的。其实验平台的团队拥有多年在网飞产品的各个方面进行实验的经验,从而不断改进网飞的用户界面、搜索、推荐、视频流等。因此,经过这些年的发展,网飞大大提高了其A/B测试平台及周围文化的成熟度。然而,虽然A/B测试对于许多类型的假设来说是很有用的工具,仍有一些原因使得某些假设无法通过A/B测试来进行。

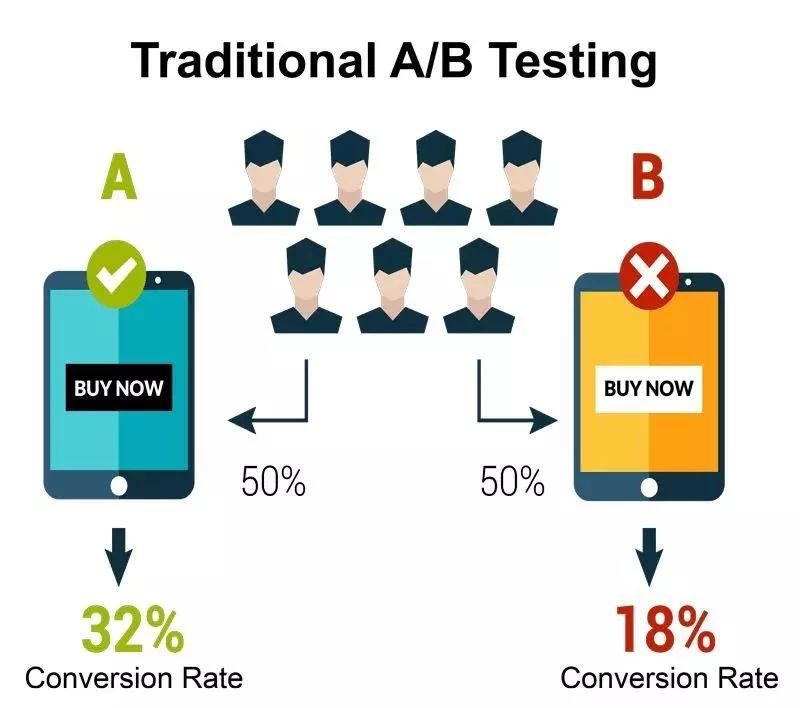

A/B测试 :对一组受众推出更改过的推广的同时保持另一组不被干扰。但要取得成功,测试中的A和B两组的受众必须是相似和随机抽取的,而有时候这是不太可能或不太实际的。

(Credit to MarTechToday)

原因一:经典的A/B测试中需要实验者从个体层面上对用户进行随机化处理。但这个要求,在很多现实场景中是不太可行的。比如你正在使用的一些媒介方式无法寻迹你的用户来自哪里,从而没有办法区别出这些正在接受你讯息的受众并且将他们做一个随机处理。

原因二:即便我们可以对目标实验用户进行随机化处理,但不同实验处理下的用户群之间可能会通过口口相传、大众媒体或甚至网飞自己的排名系统而互相干扰,从而违背了个体处理稳定假定(SUTVA),使实验结果有偏差。

SUTVA: 个体处理稳定假设stable unit treatment value assumption, 是在因果推断中一个非常重要的假设,包括两个部分:①任何个体的潜在结果不受其他个体所接受处理的影响;②每一个个体所接受的处理水平是唯一的,所导致的潜在结果也是唯一的。

举个例子, 假设我们想更好地理解两种营销手段之间的交互影响。一种是在会员内部的产品体验中推广某个特定的影片,另一种是在户外广告牌上推广这个影片。我们想知道,这两种营销手段是互相促进的还是会互相蚕食?也就是说假如一个用户在自己的会员推荐页看到了网飞推荐了一部电影,当TA再一次在户外广告中也看到网飞为这部电影打的广告以后,是会促使TA更加想去看这部电影还是反而使TA不想看了呢?

如何衡量这个变化的影响呢?

通常,我们希望做一个经典的基于个体层面的随机试验,但是要做到随机化具体哪些人看到广告牌的广告而哪些人看不到是不可能的。不过,虽然我们不能随意分配个体,但我们可以随机地选择一些城市,在其中的一些城市展示这个广告牌,而另一些城市则不进行展示。然后,我们就可以查找特定时间点实验组地域中的变化,并与对照组地域进行对比。但由于变化一直在发生(即对照组即使不受任何处理也在自然发生变化),我们就需要结合历史数据,来看出哪些变化是自然发生的,哪些是由于广告牌的影响发生的,这样才能确定测试带来的影响。

这种通过降低对变量的控制水平,增强现实性的方法就被称为准实验(quasi-experiment)。但因为各组中的个体是基于地理位置分配的,而不是直接对每个个体进行随机分配,没有基于个体的随机化,对照组和实验组之间会由于存在统计上的偏态和异质性而比严谨的A/B测试有更大几率的不平衡,因此准实验的结果相比A/B测试不会那么准确。

如何提高准实验结果准确度

那我们在准实验中该如何提高实验的准确度呢?

我们可以通过增加实验中的比较次数来提高统计效力。其实,除了观测营销活动上线时的效果,我们还可以去看当营销活动被撤掉以后,用户表现是否会逐渐返回基准线水平。营销活动的下架其实也是衡量营销活动影响的另一个机会。

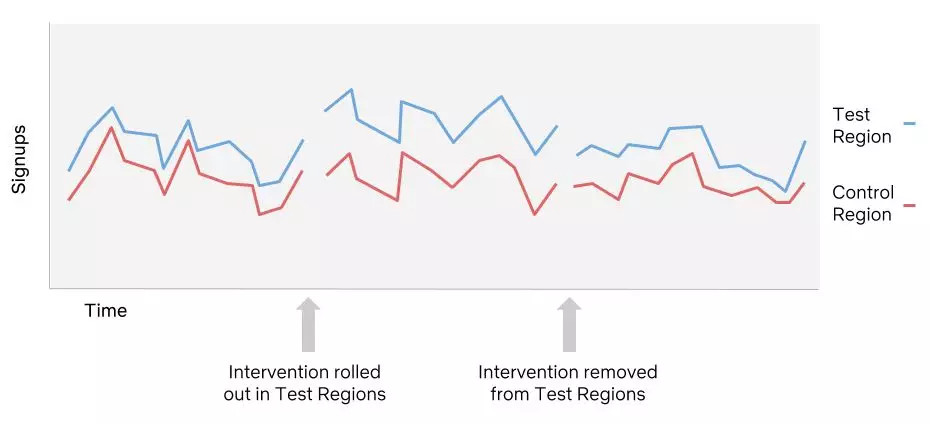

在之前探究某电影室外广告牌投放效益的例子中,我们以这部电影的用户注册率为因变量,并选定了在哪些地域投放户外广告(也就是实验组地域,test region)、哪些地域不投放户外广告(也就是对照组地域,control region)。当营销活动还没上线的时候,我们先记录下两地用户注册率的表现,并以此作为基准线,再在实验组地域加入营销活动的干预,同时记录两种地域里用户注册率的变化。然后,我们再把实验组地域的营销活动撤下,并再次两地记录用户注册率。根据我们的预想,在营销活动被撤下后,用户注册率会回归到没有营销活动时的基准线状态。

如下图所示,蓝色的线代表实验组地域(也就是投放户外广告的地域)的用户注册率变化,红色的线代表对照组地域(没有投放户外广告的地域)的用户注册率变化。在营销活动(下图所指的intervention)发生之前,这两个地域的注册率表现非常相似,在实验组地域的营销活动发生之后,两地的用户注册率差异开始变大(实验组地域的注册率显著高于对照组地域的注册率)。在一段时间的营销活动发生之后,当我们把营销活动撤下,两组地域的注册率差异又与干预发生之前的表现趋于一致,这样就可以证明户外广告投放对网飞用户注册率的提高有显著影响。

(Credit to Medium)

在此基础上,我们还可以在不同的地域做同样的测试,即先做广告,再撤掉,同时监测用户注册率的变化。因为我们不可能在测试中达成完全的变量控制(变量控制指的是,除了“是否投放户外广告”这个变量在两组间不同外,不能有其他因素在两组间不同。实际中当然是不可能的,不同的地域在很多维度上都不同),所以在多个地域重复做相同的测试可以一定程度地起到排除混淆因素的作用(因为当实验的地域足够多,混淆因素本身就被随机化了)。通过这样的方法,或是以此为基础的更为复杂的方法,我们可以有效提高准实验方法的准确率。

在内容投放方面,网飞对其各个服务器(Server)也使用了类似的准实验设计,通过随机化服务器(而非随机化用户)来调整各个服务器的内容投放机制并比较各个服务器下总体的用户反馈,来不断优化服务器的投放效果。

小程序

扫码打开微信小程序

小程序

扫码打开微信小程序

APP下载

扫码下载市场部网 App

APP下载

扫码下载市场部网 App